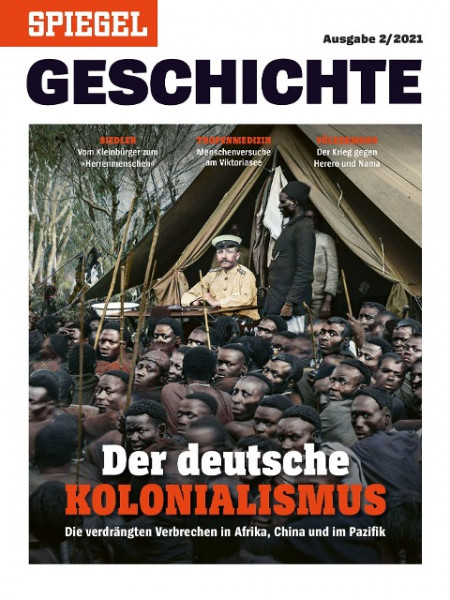

Der deutsche Kolonialismus

Kurzinformation

inkl. MwSt. Versandinformationen

Artikel zZt. nicht lieferbar

Artikel zZt. nicht lieferbar

Beschreibung

Seit 1884 war Deutschland eine Kolonialmacht. Und doch sind Details über die deutsche Kolonialzeit in der breiteren Öffentlichkeit kaum bekannt: Nicht nur in Afrika hatte Deutschland Kolonien, sondern auch in China und Ozeanien. Doch im deutschen Geschichtsunterricht kam die Epoche bei vielen kaum zur Sprache, in der öffentlichen Debatte spielt sie keine Rolle. Und so hört man bis heute immer wieder die Behauptung, Deutschland sei kolonial unbedeutend oder weniger brutal gewesen als andere Staaten. Wie es wirklich war, darüber berichtet die aktuelle Ausgabe von SPIEGEL GESCHICHTE. Das Magazin liefert Grundlagenwissen über den deutschen Kolonialismus: Es erklärt, welche Rolle Deutschland im Kolonialismus spielte - und warum die Auswirkungen dieser Zeit noch heute zu spüren sind. Es zeigt, dass der Wunsch nach Beherrschung ferner Länder nicht "von oben" aus der Politik kam, sondern in der Gesellschaft tief verwurzelt war. Es erläutert, warum der Rassismus eine entscheidende Grundlage für die koloniale Ausbeutung war. Und es macht deutlich, welche Verbrechen deutsche Beamte und Soldaten in den Kolonien begingen. Im Mittelpunkt dieses Heftes steht die Perspektive der Menschen aus den Kolonien: Anhand beispielhafter Schicksale sowie der Schilderungen von Zeitzeuginnen und Zeitzeugen beschreibt SPIEGEL GESCHICHTE, was die Einheimischen nach der Besetzung ihrer Länder durch die Deutschen erlebten, wie sie etwa von Missionaren oder Ärzten behandelt wurden oder auf welche Weise sie sich gegen die Besatzer wehrten. In der Gesamtschau wird deutlich: Die Deutschen profitierten nicht erst seit 1884 vom Kolonialismus, und der koloniale Gedanke endete nicht 1918. Eine gesellschaftliche Auseinandersetzung mit der deutschen Kolonialzeit und ihren Folgen ist überfällig - dieses Heft liefert dafür Impulse. von Augstein, Rudolf

Produktdetails

So garantieren wir Dir zu jeder Zeit Premiumqualität.

Über den Autor

- Gebunden

- 352 Seiten

- Erschienen 2017

- Bebra Verlag

- paperback

- 560 Seiten

- Erschienen 2009

- Bibliobazaar

- perfect -

- Erschienen 1985

- Stuttgart : Klett,

- Kartoniert

- 373 Seiten

- Erschienen 2012

- De Gruyter Oldenbourg